Нейронная соната: как искусственный интеллект генерирует музыку

Можно ли автоматизировать творчество и оцифровать музу? Разбираемся, действительно ли нейросети претендуют на создание музыкальных шедевров

Об эксперте: Ольга Перепелкина, эксперт в области машинного обучения и нейросетей, преподаватель и автор курса Affective Computing в ВШЭ.

Творчество всегда считалось прерогативой человечества. И если в когнитивных задачах, таких как вычисления и обработка информации, мы уже признали превосходство искусственного интеллекта и активно пользуемся плодами автоматизации, то в таких «человеческих» видах деятельности как живопись, поэзия или композиторство алгоритмы нам уступают. И вообще, разве можно поставить на поток производство шедевров? Однако задачей автоматического создания картин, стихов и музыки ученые занимаются уже несколько десятилетий, и некоторые успехи определенно достигнуты.

Первая музыка, созданная с использованием компьютера, появилась в 1957 году в Bell Laboratories. Это была композиция длиной 17 секунд, которую ее автор Ньюман Гутман назвал The Silver Scale («Серебряная чешуя»):

В том же году The Illiac Suite стала первой партитурой, написанной компьютером. Она был названа в честь компьютера ILLIAC I университета штата Иллинойс в США. Это ранний пример алгоритмической композиции, основанной на вероятностном моделировании (цепях Маркова). В области синтеза звука знаменательным событием стал выпуск синтезатора DX 7 компанией Yamaha в 1983 году, использующего модель синтеза на основе частотной модуляции (FM).

Генерация музыки

Когда мы говорим о создании музыки при помощи компьютера, речь может идти как об ассистивной системе или компьютерной среде, помогающей музыкантам (композиторам, аранжировщикам, продюсерам), так и об автономной системе, нацеленной на создание оригинальной музыки. В обоих типах систем могут участвовать нейросетевые алгоритмы и глубокое обучение.

В обоих типах систем могут участвовать нейросетевые алгоритмы и глубокое обучение.

Мы также можем говорить о разных этапах создания музыки, где искусственный интеллект встраивается в процесс и помогает нам: сочинение, аранжировка, оркестровка и т.д. Когда человек сочиняет музыку, он редко создает новое произведение с нуля. Он повторно использует или адаптирует (сознательно или бессознательно) музыкальные элементы, которые слышал ранее, а также руководствуется принципами и рекомендациями из теории музыки. Так и компьютерный помощник может включаться на различных этапах создания произведения, чтобы инициировать, предлагать или дополнять композитора-человека.

Генерация нот

Традиционным подходом является создание музыки в символической форме. Результатом процесса генерации может быть музыкальная партитура, последовательность событий MIDI (распространенный стандарт цифровой звукозаписи), простая мелодия, последовательность аккордов, текстовое представление или какое-либо другое представление более высокого уровня. То есть искусственный интеллект создает символическую форму, по которой затем можно сыграть произведение.

То есть искусственный интеллект создает символическую форму, по которой затем можно сыграть произведение.

Иными словами, физический процесс, посредством которого создается звук, упраздняется — вместо создания всего многообразия аудиосигнала, алгоритм выдает «инструкцию». Это резко сокращает объем информации, которую алгоритмы должны производить, что сводит проблему синтезирования к более решаемой и позволяет эффективно использовать простые модели машинного обучения.

Такой подход, например, позволил создать музыку в стиле Баха. Другой пример — нейросеть от OpenAI Musenet, которая появилась в апреле 2019 года. MuseNet может сочинять четырехминутные композиции на десяти инструментах и комбинировать стили «от Моцарта до Beatles». Эта нейросеть была обучена на огромном массиве MIDI-записей.

Генерация аудио

Но символический подход не позволяет создать нюансы человеческого голоса и различные характеристики тембра, динамики и выразительности музыкального произведения. Другой способ — это создавать музыку напрямую в виде аудиосигнала. Сложность этого подхода в том, что последовательность, которую мы в таком случае пытаемся создать — очень длинная. Например, для песни в несколько минут в хорошем студийном качестве это будет десятки миллионов значений.

В апреле 2020 года, компания OpenAI выпустила Jukebox, — нейросеть, которая генерирует музыку в различных жанрах. Она может сгенерировать даже элементарный голос, а также различные музыкальные инструменты. Jukebox создает аудиосигнал напрямую, минуя символьное представление. Такие музыкальные модели имеют гораздо большую емкость и сложность, чем их символьные аналоги, что подразумевает более высокие вычислительные требования для обучения модели.

Как творят нейросети?

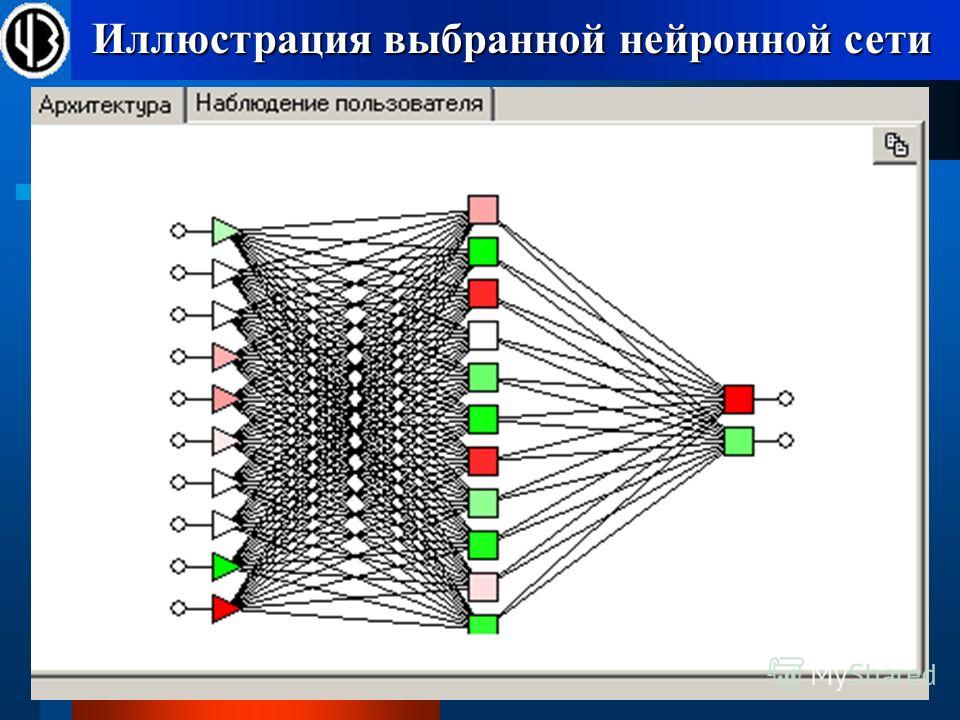

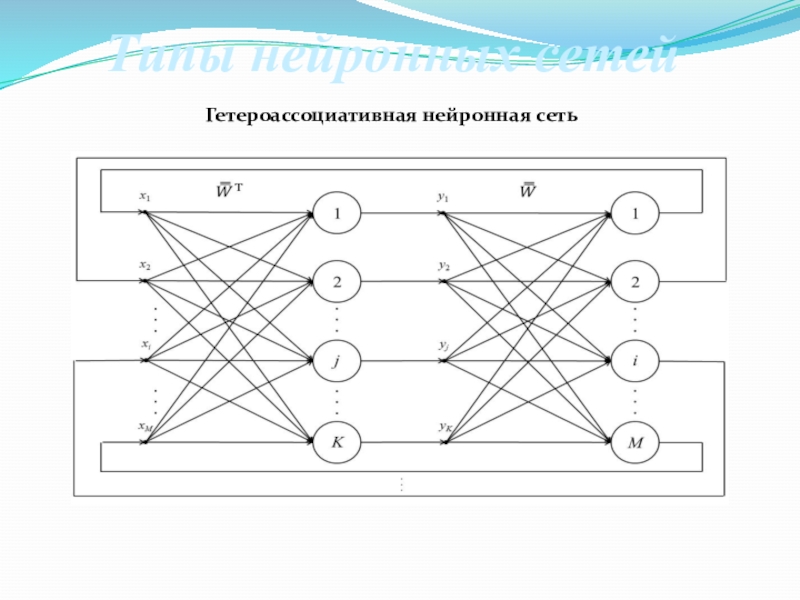

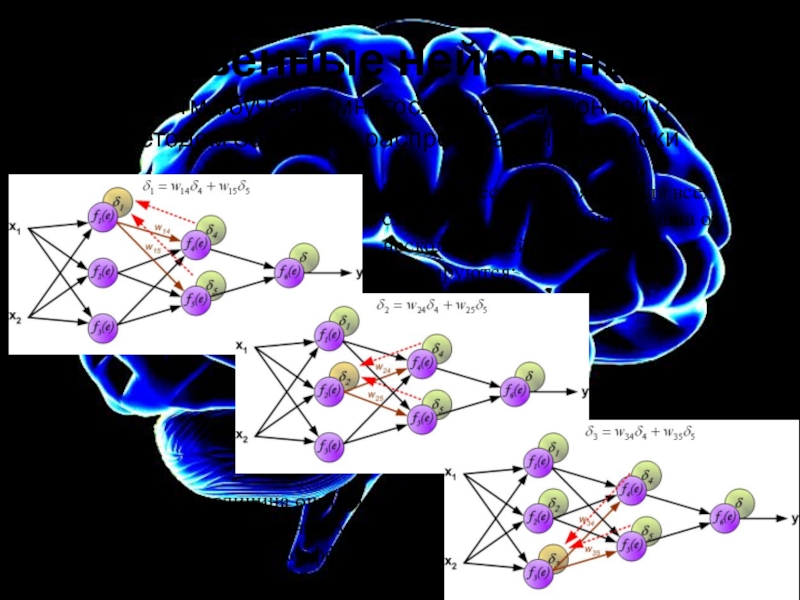

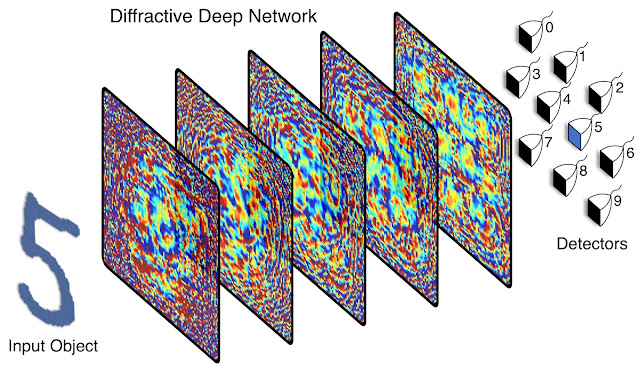

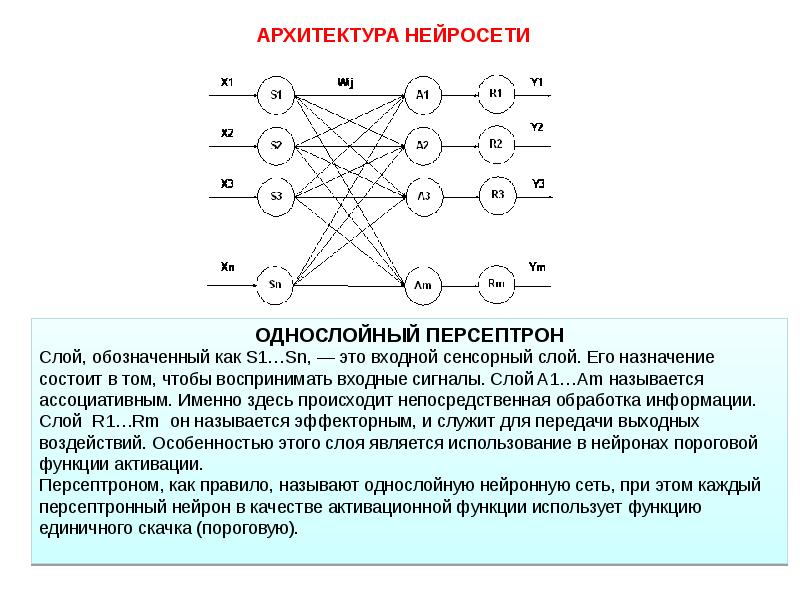

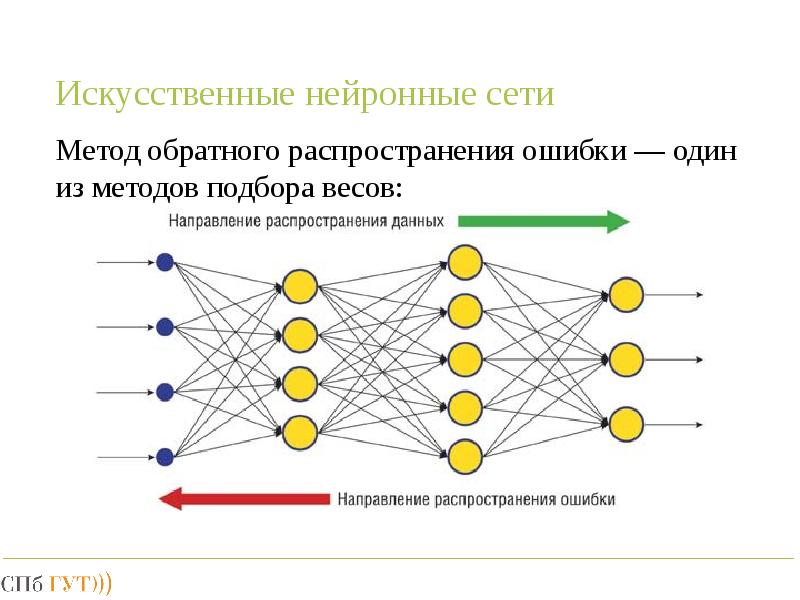

Как же именно нейросети создают музыку? Общий принцип заключается в том, что нейросеть «смотрит» на огромное количество примеров и учится генерировать что-то похожее. В основе таких алгоритмов обычно лежат автокодировщики и генеративно-состязательные нейросети (Generative Adversarial Network, GAN).

Автокодировщик — это нейросеть, которая учится представлять сложный и многомерный набор данных в «упрощенном» виде, а затем из этого упрощенного представления снова воссоздать исходные данные. То есть модель генерации музыки на основе автокодировщика сначала сжимает необработанный звук в пространство меньшей размерности, отбрасывая некоторые из несущественных для восприятия битов информации. Затем мы обучаем модель генерировать звук из этого сжатого пространства и повышать качество до исходного звукового пространства.

Генеративно-состязательную нейросеть метафорично можно представить как работу «фальшивомонетчика» и «следователя».

Для обучения модели Jukebox использовал базу данных из 1,2 млн песен (600 тыс. из которых на английском языке), которая включала как сами композиции, так и тексты песен и метаданные — исполнителя, жанр и ключевые слова.

Музыкальный тест Тьюринга

Как понять, что музыкальное произведение, созданное машиной, действительно достойно нашего внимания? Для проверки работы систем искусственного интеллекта был придуман тест Тьюринга. Его идея заключается в том, что человек взаимодействует с компьютерной программой и с другим человеком. Мы задаем вопросы программе и человеку и пытаемся определить, с кем же мы разговариваем. Тест считается пройден программой, если мы не можем отличить программу от человека.

В области генерации музыки иногда используют «музыкальный тест Тьюринга». Так, например, был протестирован алгоритм DeepBach, который генерирует ноты в стиле Баха. Были опрошены более 1,2 тыс. людей (как эксперты, так и обычные люди), которые должны были отличить реального Баха от искусственного. И оказалось, что сделать это очень сложно — люди с трудом могут различать хоралы, сочиненные Бахом, и созданные DeepBach.

В области создания аудио успехи пока не столь впечатляющие. Несмотря на то, что Jukebox представляет собой смелый шаг вперед в плане качества музыки, длины аудио и способности настроиться на исполнителя или определенный жанр, различия между искусственной музыкой и произведениями, созданными людьми, все еще заметны. Так, в мелодиях от Jukebox хоть и есть традиционные аккорды и даже впечатляющие соло, мы не слышим крупные музыкальные структуры, такие как повторяющиеся припевы. Также в искусственных произведениях слышны шумы, связанные со способом работы моделей. Скорость генерации музыки также пока еще невысока — для полного рендеринга одной минуты звука с помощью Jukebox требуется около девяти часов, поэтому их пока нельзя использовать в интерактивных приложениях.

Несмотря на то, что Jukebox представляет собой смелый шаг вперед в плане качества музыки, длины аудио и способности настроиться на исполнителя или определенный жанр, различия между искусственной музыкой и произведениями, созданными людьми, все еще заметны. Так, в мелодиях от Jukebox хоть и есть традиционные аккорды и даже впечатляющие соло, мы не слышим крупные музыкальные структуры, такие как повторяющиеся припевы. Также в искусственных произведениях слышны шумы, связанные со способом работы моделей. Скорость генерации музыки также пока еще невысока — для полного рендеринга одной минуты звука с помощью Jukebox требуется около девяти часов, поэтому их пока нельзя использовать в интерактивных приложениях.

А как же лирика?

Хорошо, с музыкальными композициями разобрались, а как же тексты для песен? Может ли искусственный интеллект сочинять стихи? Да, и эта задача даже проще, чем написание мелодий, хотя и сложностей здесь тоже хватает — алгоритму нужно не только «придумать» осмысленный текст, но и учесть его ритмическую структуру.

В 2016 году разработчики «Яндекса» выпустили альбом «Нейронной обороны». В него вошли 13 песен в стиле «Гражданской обороны», тексты для которых сочинил искусственный интеллект. А годом позже вышел альбом «Neurona» с четырьмя песнями в стиле Nirvana, стихи для которых также были сгенерированы нейросетями.

Сейчас спою

Музыку мы создавать научились, стихи для нее писать — тоже, а как же быть с человеческим голосом? Могут ли нейросети петь вместо нас?

Генерация реалистичного человеческого голоса нужна не только для пения, но и во многих системах — от call-центров до личных голосовых помощников. Еще в 2016 году компания DeepMind выпустила алгоритм WaveNet, который создает очень реалистичный голос по заданному тексту (Text-To-Speech). Технология доступна для двух языков — английского и китайского.

В апреле 2020 года в ByteDance AI Lab (лаборатории компании, создавшей знаменитый TikTok) создали алгоритм ByteSing. Эта система на основе нейросетевых автокодировщиков позволяет генерировать очень реалистичное пение на китайском языке.

Большинство разработчиков современных алгоритмов генерации музыки, стихов и пения отмечают, что их системы являются ассистивными. Они не претендуют на полноценную замену человеческого творчества, а, напротив, призваны помочь человеческой музе. Человек не перестанет творить по мере развития алгоритмов и программ, но будет использовать их в своей деятельности. Очень вероятно, что в будущем великие шедевры будут созданы людьми и искусственным интеллектом совместно.

Искусственный интеллект научился сочинять музыку, совсем как человек

Уроки истории

Эд Ньютон-Рекс по образованию композитор. Он работал над проектом Jukedeck с 2014 года — со временем его команда выросла до 20 человек и смогла привлечь $3,1 миллиона инвестиций.

«Все началось с того, что еще будучи студентом, я задал себе вопрос: а могут ли уже компьютеры сочинять музыку? — рассказал основатель стартапа. — Я решил, что они наверняка должны это уметь, и задумался, какой смысл будет в этом умении.

Каким удивительным образом его можно будет использовать? В итоге я отправился к подруге в Гарвард, где она как раз изучала компьютерные науки. Я посетил что-то вроде вводной лекции в информатику и понял, что в принципе вполне реально научить компьютер писать музыку.

Я начал работать над прототипом — тогда он представлял собой элементарную систему алгоритмического написания музыки. Работа была сложной, и на нее ушло много времени, но в итоге мне удалось сделать довольно неплохой прототип. Я отвез его в инвестиционное подразделение Кембриджского университета, чтобы получить финансирование».

Фото: Andrii Degeler

ИИ Jukedeck пишет музыку с помощью нейронных сетей — один из многочисленных методов, которые использовались в истории для написания компьютерной музыки. Первые известные эксперименты в этой области проводились еще в 50-х годах XIX века. Первой, кто заговорил о попытках написания машиной музыки, была изобретательница двоичного кода Ада Лавлейс. В 1843 году она написала, что «аналитическая машина Чарльза Бэббиджа может сочинять осмысленные отрывки музыки любой сложности и длины».

В 1843 году она написала, что «аналитическая машина Чарльза Бэббиджа может сочинять осмысленные отрывки музыки любой сложности и длины».

Спустя столетия композитор Лейярен Хиллер и программист Леонард Айзексон написали с помощью искусственного интеллекта сюиту «Иллиак». При ее создании ИИ опирался на правила теории музыки. Для своего времени получившееся произведение звучало довольно неплохо.

В XX веке появился еще один способ написания компьютерной музыки — на этот раз с помощью грамматики. Проще говоря, ИИ пытался проанализировать систему строения музыки и создать по ней собственную мелодию. Среди известных людей, пользовавшихся этим методом, был американский ученый и композитор Дэвид Коуп. Благодаря его идее «рекомбинаторики» появился искусственный интеллект, который мог анализировать существующие музыкальные отрывки и на их основе создавать собственные. Вот так, например, звучит имитация произведения Вивальди:

youtube.com/embed/2kuY3BrmTfQ»/>

Для написания музыки использовалась и так называемая цепь Маркова (система, чье текущее состояние зависит только от предыдущего), ведь ее концепция очень напоминает принцип создания музыки. Так появился алгоритм Continuator, созданный ученым Франсуа Паше, который может продолжать сочинять музыкальное произведение с того места, где остановился живой композитор.

Еще один метод, которым пользовались для создания музыки с помощью ИИ, это эволюционные алгоритмы. Именно их использует проект британских ученых DarwinTunes. Согласно его основному принципу, любой желающий может прослушать различные отрывки музыки и выбрать из них те, что понравились больше всего. Прошедшие такой «естественный отбор» фрагменты эволюционируют, то есть воспроизводятся в новых вариациях.

Вот, например, одна из композиций DarwinTunes:

Несмотря на то, что с помощью этих методов действительно можно сочинять неплохую музыку, у них всегда есть ограничения. Либо они слишком зависят от теории музыки, либо все сводится к индивидуальным предпочтениям человека, который отбирает лучшие образцы созданной музыки.

Либо они слишком зависят от теории музыки, либо все сводится к индивидуальным предпочтениям человека, который отбирает лучшие образцы созданной музыки.

Работа нейронных сетей

По словам Ньютона-Рекса, самой большой технологической трудностью в создании ИИ, который смог бы писать музыку, является то, что не существует «хорошей» или «плохой» музыки. Если взять, к примеру, распознавание изображений с помощью нейронных сетей, то там можно научить алгоритм анализировать, какая картинка правильная, а какая нет.

Но с музыкой так не получится, потому что не существует универсального определения, что такое «хорошая» музыка. Музыканты, работающие над Jukedeck, поставили перед собой цель выработать у алгоритма музыкальный вкус и навыки написания музыки.

«Мы слушаем музыку, оцениваем результат и корректируем сети нужным образом, — рассказал Ньютон-Рекс. — При корректировке мы полагаемся на собственный слух (в конце концов, мы же музыканты!) и на количество скачиваний композиций с нашего сайта («стали ли люди скачивать музыку чаще после внесенных изменений?»).

Мы используем эти два метода потому что алгоритмическое написание музыки по-прежнему находится на очень раннем этапе развития».

«Стоит отметить, что сама система сильно отличается от того, как работают эволюционные методы, — добавил Ньютон-Рекс. — По эволюционному методу пользователь отбирает лучшие результаты, и система пересоздает их с новыми вариациями — и так до бесконечности. Система ничему не учится. А когда мы используем нейросети, она анализирует данные своего обучения и творит уже на их основе».

Квиз №1. Сможете угадать, какой из этих двух музыкальных фрагментов написан компьютером?

Заменит ли компьютер живых музыкантов?

Несмотря на то, что человечество проводит эксперименты в плане написания музыки с помощью ИИ вот уже более 50 лет, считается, что эта технология еще находится на ранней стадии развития. Однако будущее ее выглядит светлым — по крайней мере, так считают те, кто с ней работают.

«Я очень удивлюсь, если через 10-15 лет большинство музыкальных произведений будет создаваться с помощью искусственного интеллекта», — сказал Ньютон-Рекс.

Это значит, что в будущем композиторам — в частности тем, кто пишет музыку на заказ — возможно, придется искать другую работу.

Сами композиторы пока что не сильно беспокоятся на этот счет. Дмитрий Лившиц, скрипач, инженер звукозаписи и лучший композитор на популярной площадке стоковой музыки считает, что искусственный интеллект и проект Jukedeck смогут достичь мастерства человека еще лишь спустя много лет.

«Электроника звучит более-менее нормально, — сказал он после прослушивания музыки, созданной Jukedeck. — А вот гитары в рок-композициях просто ужас. У такой музыки немного синтетическое звучание, но, думаю, для тех, кто не задумывается, что играет на фоне, сойдет. Рекламные агентства, конечно же, не станут использовать эту музыку, а вот влогеры на YouTube вполне могут».

Лившиц согласен, что когда ИИ сможет создавать действительно хорошую фоновую музыку для видеоблогов и рекламных роликов, стоковым композиторам действительно придется искать новый вид заработка. Однако он не выразил сожаления и заявил, что уже «сотрудничает» с ИИ — а именно пользуется приложением, которое генерирует музыкальные идеи и тем самым помогает композиторам, у которых пропало вдохновение.

Квиз №2. Давайте попробуем еще раз. Какой из этих треков написан компьютером?

Еще один популярный композитор стоковой музыки Олександр Игнатов назвал музыку, создаваемую ИИ, «фастфудным решением» для тех, кому срочно нужна дешевая музыкальная композиция.

«Только образованные люди могут создать произведение искусства, которое будет нести в себе какую-то мысль, — заявил он. — Сомневаюсь, что искусственный интеллект сможет когда-нибудь написать саундтрек к фильму, который бы вызывал мурашки.

Машина на такое не способна».

У Ньютон-Рекса другая позиция на этот счет. Он считает, что с помощью творческого ИИ написание музыки станет занятием, доступным более широкой аудитории.

«Сейчас создание музыки — это занятие, доступно только элите, — сказал он. — Чтобы хорошо писать музыку, нужно получить дорогое образование и долго учиться. Музыкальное творчество недоступно большинству людей. ИИ сможет решить эту проблему. С его помощью люди смогут писать музыку, а значит ее станет больше, и она будет более персонализированной».

Однако именно этого и боятся некоторые композиторы.

«Инструменты, позволяющие генерировать музыку, с одной стороны являются отличными помощниками для композиторов, — сказал Владимир Поникаровский, композитор стоковой музыки, который сейчас перешел в индустрию разработки игр. — С другой же, если ими будет пользоваться огромное количество людей, на свет появится тонна некачественного контента, из-за чего может в среднем упасть качество стоковой музыки».

Но Ньютон-Рекс спешит развеять все опасения о том, что ИИ окажет негативный эффект на музыку в целом. По его словам, когда-то все точно так же возмущались по поводу электронных инструментов, и даже было движение против синтезаторов. В итоге благодаря технологическим инновациям в музыке на свет появились целые новые музыкальные жанры — и в будущем может произойти то же самое благодаря ИИ.

А что насчет денег?

Сейчас Jukedeck продает свою музыку по стоимости от $21,99 до $199 (в зависимости от типа лицензии). Частные лица и представители малого бизнеса могут получить неэксклюзивную лицензию бесплатно.

У Jukedeck нет специальной системы для защиты музыки от нелегального копирования, поэтому стартапу приходится полагаться лишь на честность своих клиентов. Хотя, возможно, вскоре ситуация изменится.

«В самом начале мы делали музыку для видеороликов, — рассказал Ньютон-Рекс. — Мы создавали ее для видеоблогеров на YouTube и не монетизировали ее.

Мы думали так: «Давайте докажем всем, что наша музыка хороша, и ей захотят пользоваться люди». Сейчас же на нашем сайте более полумиллиона композиций. Пока что мы не объявили о следующем шаге, но вообще рассматриваем различные области видеорынка, где могли бы монетизировать свои произведения. Именно этим мы планируем заниматься в ближайшие несколько месяцев».

Представители музыкальной индустрии и крупные игроки технологического рынка тоже обратили внимание на возможность сочинять музыку с помощью ИИ. Например, у Sony есть собственное средство для создания музыки под названием Flow Machines, о котором прошлой осенью много писала пресса. Этот ИИ создал песню под названием Daddy’s Car в стиле The Beatles.

Для Ньютон-Рекса и его проекта Jukedeck появление таких новых игроков с большими ресурсами, означает, что конкуренция на рынке станет гораздо жестче. А для рядового слушателя это значит лишь то, что довольно скоро его ждут совершенно новые музыкальные впечатления.

А для рядового слушателя это значит лишь то, что довольно скоро его ждут совершенно новые музыкальные впечатления.

Источник.

Материалы по теме:

Блокчейн может изменить музыкальную индустрию

Искусственный интеллект научили писать музыку для «активности мозга»

Сотрудники Яндекса записали альбом на стихи, созданные нейросетью

Google научит искусственный интеллект рисовать и сочинять музыку

«Нейронная оборона» и «новый Рембрандт». Как нейросети пишут музыку, картины, киносценарии

Футурологи говорят, что скоро алгоритмы отберут у людей монотонную работу, — программы будут вести бухучет, управлять автомобилями, штамповать детали на заводах. А вот творческим специалистам — художникам, писателям, музыкантам — нечего бояться, по тем же прогнозам. Но сегодня нейросети пишут новые тексты, музыку, картины. Одни проекты подаются как постдокументализм, где автор играет с новыми технологиями в своем проекте, в других замыслах — нейросеть может помогать творцу. А есть картины, сгенерированные алгоритмами, которые уже продаются за деньги. Что думают об этом композиторы, художники и разработчики?

А есть картины, сгенерированные алгоритмами, которые уже продаются за деньги. Что думают об этом композиторы, художники и разработчики?

Курт Кобейн и Егор Летов. Возрожденные нейросетью

«А в глазах у тебя апельсиновый снег, и не будет в помине озлобленных птиц». «Дождик по миру брел живой, за собой вел свои войска».

Одна из цитат принадлежит Егору Летову, лидеру группы «Гражданская оборона». Другая — творение алгоритма, которого предварительно «накормили» песнями панк-рокера, а заодно всей русской поэзией.

Вы, скорее всего, не догадаетесь, где генеративная строчка, а где та, в которую Летов вкладывал чувства. Второй вариант — настоящая «Гражданская оборона».

Давайте еще раз — где Летов, а где алгоритм: «Мне будет сниться, ты можешь сбиться, и как много лет назад, в гости к богу в Ленинград», «Он гремит сапогами, но упал — гололед, и мы — лед под ногами майора».

Спецпроект на тему

В 2016 году Иван Ямщиков и Алексей Тихонов — разработчики «Яндекса» — выпустили альбом «Нейронной обороны» из 13 песен, куда вошла и песня с первой строчкой (про бога и Ленинград). Тогда многие поклонники удивлялись, не могли отличить генеративные тексты от Летова — настолько лирика была выдержана в его стиле.

Тогда многие поклонники удивлялись, не могли отличить генеративные тексты от Летова — настолько лирика была выдержана в его стиле.

«Нейросеть не может выдать осмысленный и связный текст. Мы собирали стихи по одной строчке, — объясняет Иван Ямщиков. — Видим интересную строку — оставляем, ищем ей «пару» и так далее. Видим неинтересную — пропускаем. Но мы ничего не дописывали, все, что есть в текстах «Нейронной обороны», создано нейросетью. Потом мы сочиняли музыку и сами исполняли песни».

Ямщиков и Тихонов выбрали Егора Летова для эксперимента после того, как поняли принцип: алгоритм хорошо стилизует творцов, у которых в текстах много странных и абсурдных образов. Алгоритм выдавал убедительного Даниила Хармса, но сомнительного Пушкина. Егор Летов с его оразами в духе «трогательным ножичком пытать свою плоть» подходил, а еще он просто нравился создателям. «Нейронная оборона» стала успешнее, чем Neurona — альбом Курта Кобейна, который разработчики выпустили спустя год после «возрождения» Летова.

«Нейронную оборону» послушали несколько сотен тысяч человек, а Neurona — около сотни тысяч, — говорит Ямщиков. — Но в первом случае мы собрали русскоязычную аудиторию, а во втором — англоязычную. Можно было лучше продвигать альбом, но это не наша специализация. Мы показываем эти работы на разных IT-конференциях. И делали их для того, чтобы показать людям, что умеют нейросети».

‘ Youtube/Creaited Labs’

Над лирикой Курта Кобейна работали около полугода. «Сначала мы дали нейросети тексты Кобейна и всю английскую поэзию, — вспоминает Ямщиков. — Первые эксперименты показали, что тексты выходят не очень грамотными, дело в том, что в дата-сете были данные с платформ, куда любые желающие могут загрузить свои произведения, — а там есть стихи, написанные не носителями языка. Мы почистили дата-сет и получили симпатичные вещи».

«Наши первые эксперименты в 2016 году удивляли людей, а сейчас примеров того, как алгоритмы пишут музыку, тексты, картины, — много, — рассуждает Иван Ямщиков. — Это вообще интересный общественный процесс. Со второй половины XX века мы живем в мире постмодернизма, когда все уже придумано, сказано, написано, а творцы берут идеи и играют с ними, как с кубиками «Лего». И вот появляется нейросеть и говорит: «Я тоже могу играть в кубики «Лего». Технологии будут развиваться и в этой сфере и пойдут дальше. Представьте, что у вас дома есть не просто картина, написанная нейросетью, а интерактивная картина с сенсорами, датчиками, которая улавливает ваше настроение и в зависимости от него меняет изображение. Или она меняет «картинку» под каждого члена семьи. Вот то будущее, о котором сейчас говорят на научных и IT-конференциях, связанных с машинным обучением».

— Это вообще интересный общественный процесс. Со второй половины XX века мы живем в мире постмодернизма, когда все уже придумано, сказано, написано, а творцы берут идеи и играют с ними, как с кубиками «Лего». И вот появляется нейросеть и говорит: «Я тоже могу играть в кубики «Лего». Технологии будут развиваться и в этой сфере и пойдут дальше. Представьте, что у вас дома есть не просто картина, написанная нейросетью, а интерактивная картина с сенсорами, датчиками, которая улавливает ваше настроение и в зависимости от него меняет изображение. Или она меняет «картинку» под каждого члена семьи. Вот то будущее, о котором сейчас говорят на научных и IT-конференциях, связанных с машинным обучением».

«Башмет сказал: «Да, здорово звучит». О пьесе нейросети

Нейросеть от разработчиков «Яндекса» стала соавтором пьесы, которую исполнил оркестр под руководством Юрия Башмета на прошлогоднем Зимнем фестивале искусств в Сочи.

На эту тему

«Цифровой восход» — так назвали пьесу — длится восемь минут, для ее создания алгоритму «скормили» четыре гигабайта произведений классиков — от Баха и Шнитке до Прокофьева и Шостаковича. Бот сгенерировал мелодии, которые собирал в готовое произведение композитор Кузьма Бодров.

Бот сгенерировал мелодии, которые собирал в готовое произведение композитор Кузьма Бодров.

«Это была идея организаторов фестиваля, — рассказывает он. — Разработчики сами работали с нейросетью, а я получил от них 20–25 аудиодорожек — каждая примерно по три минуты. Большая часть из них — бессвязные. Но я вычленил три-четыре интересных мотива — этого было достаточно — и дал им развитие и форму. Эти мотивы — странные, я бы так не придумал, но в них были какие-то проблески интонаций, которые меня зацепили».

На «сборку» у Бодрова ушло две недели. «Иногда две недели можно только искать идею — с чего начать? Здесь же миллиарды вариантов. А в этом случае мне не нужно было придумывать — основа дана».

На эту тему

Нейросеть создала оригинальные мелодии, но по стилю они напоминали американский минимализм. «Там паттерн много-много раз повторяется, — продолжает Бодров. — Я могу сказать, что получилось хорошо. Музыкантам понравилось, они говорили: «Клево», «Интересно». Но главная оценка — это слова Юрия Абрамовича Башмета. Он послушал и сказал: «Да, здорово звучит. Симпатичная вещь получилась».

Он послушал и сказал: «Да, здорово звучит. Симпатичная вещь получилась».

Кузьма Бодров раньше не использовал алгоритмы в создании композиций. А вообще музыканты регулярно экспериментируют с нейросетями. Пару лет назад победители конкурса классической музыки в Германии использовали бота для создания мелодии.

Новый Рембрандт…

В апреле 2016 года команда разработчиков, спонсируемая Microsoft и голландским банком ING, показала обществу проект «Следующий Рембрандт» под лозунгом «Через 347 лет после смерти Рембрандта представлена его следующая картина».

С помощью нейросетей разработчики выявили параметры, которые делали его уникальным творцом, начиная от выбора темы работы до точных пропорций типичных рембрандтовских полотен. Получили преобладающую модель, которая представляла из себя «мужчину 30–40 лет в черном платье с белым воротником, лицо повернуто вправо». Этот комплекс параметров использовали для создания оригинального портрета, выполненного в стиле художника.

… и самая дорогая генеративная картина

Другой случай взволновал профессиональных художников. В 2017 году картина, написанная нейросетью, была продана за $432 тыс. на аукционе Christie’s в Нью-Йорке. Эксперты изначально оценивали «Портрет Эдмона Белами» в $7 тыс.

«Портрет Эдмонда Белами»

© Пресс-служба аукционного дома Christie’s«Почему это кажется почти невероятным? Аукционные продажи опираются на такие вещи, как авторство, уникальность. Автор — такой демиург, работами которого хотят обладать коллекционеры, — говорит Александр Евангели, арт-критик, преподаватель в школе им. Родченко. — И когда работа, написанная алгоритмом, оказывается в рамке, за нее идет борьба, и она продается за такую сумму, — эта основа оказывается подорвана. Рыночный механизм сохраняется, а смысл — нет».

Впрочем, это единичный случай, подавляющее большинство картин, созданных нейросетью, ничего не стоят. И цена — не критерий в сфере искусства, добавляет Евангели: «Работы дадаистов очень низко оцениваются рынком — можно купить картину за $10 тыс. , что совсем не соответствует вкладу этих творцов в культуру. Но профессионалы понимают — это искусство».

, что совсем не соответствует вкладу этих творцов в культуру. Но профессионалы понимают — это искусство».

Алгоритмы породили в арт-среде много вопросов. «Чем будет искусство через 10–15 лет — трудно сказать, но оно потеряет сегодняшние границы, — говорит Евангели. — Рынок вокруг генеративного искусства к тому времени сформируется, почему нет? Сегодня продаются копии картин –— вы можете купить совсем недорогую картину и украсить дом. И вы можете купить картину, сделанную нейросетью, пусть она ничего не стоит сверх материалов, и повесить дома. Просто у людей есть потребность в украшении окружающей среды, но это не имеет отношения к искусству, речь идет о дизайне. Искусство, во-первых, останется как человеческая практика. Ведь живописцы любят писать картины, как люди любят играть друг с другом в шахматы, хотя алгоритмы уже давно играют лучше. А во-вторых, современное искусство будет комбинировать традиционные подходы и технологии».

«Картины, написанные нейросетью, — это неинтересно»

Елена Никоноле — медиахудожник, выпускница школы им. Родченко. У нее несколько проектов, связанных с нейросетями.

Родченко. У нее несколько проектов, связанных с нейросетями.

Первый эксперимент — проект Deus X mchn: нейросеть, которая обучалась на сакральных текстах из разных мировых религий — от Ветхого завета до Корана, анализировала их параметры и в итоге написала свой текст. Это сгенерированный псевдорелигиозный текст, в котором появились несуществующие слова.

«Вражебесное», «человеколетль», — приводит пример Елена. На втором этапе проекта Никоноле вместе со своей командой получала доступ к камерам с динамиками и прочим девайсам, имеющим выход в интернет и расположенным в общественных местах разных городов мира. «Огромная часть устройств по всему миру не защищены паролем», — говорит художница. Через устройства транслировался этот псевдосакральный текст.

У художницы есть и другой эксперимент.

На эту тему

«Я обучила нейросеть на звуках пения соловья — а у них довольно сложная структура песни. Алгоритм анализировал и выделял паттерны в звуках и генерировал свои — сначала это было соловьиное пение с узнаваемыми технологическими «нотами», но по мере того, как нейросеть обучалась, она выдавала все более похожий результат. Я включала эти звуки птицам, они реагировали и начинали «разговаривать» с искусственным интеллектом. Мне было важно выразить метафору — общение искусственного разума с природой. Второй этап — алгоритм-переводчик, который сможет перевести на человеческий язык пение птиц».

Я включала эти звуки птицам, они реагировали и начинали «разговаривать» с искусственным интеллектом. Мне было важно выразить метафору — общение искусственного разума с природой. Второй этап — алгоритм-переводчик, который сможет перевести на человеческий язык пение птиц».

Никоноле считает, что эксперименты с нейросетями в искусстве будут продолжаться. «Но картины, написанные нейросетью, — это базовый уровень, это неинтересно, — говорит она. — Интереснее комбинировать и выражать смыслы через использование технологий».

Гарри Поттер и странная научная фантастика

Алогориты не умеют создавать истории, ведь они, в отличие от людей-творцов, не понимают смысла того, что делают. Этот факт иллюстрирует короткометражка по сценерию нейросети.

Sunspring — семиминутный фильм «о будущем, в котором люди столкнулись с массовой безработицей и, чтобы выжить, вынуждены продавать свою кровь». Идею, сценарий и диалоги написала программа, которой скормили много научной фантастики — от «Звездных войн» до «Терминатора». Создатели не вмешивались в «авторский замысел», потому что уловить смысл в диалогах героев почти невозможно.

Создатели не вмешивались в «авторский замысел», потому что уловить смысл в диалогах героев почти невозможно.

Еще авторы на чикагской студии Botnik использовали нейросеть для создания рассказа о Гарри Поттере. Алгоритму «скормили» романы Джоан Роулинг и попросили его написать новый. В трехстраничном рассказе «Гарри Поттер и портрет того, что выглядит как огромная куча пепла» друг Гарри — Рон — превращается в паука и пытается съесть родителей Гермионы.

Есть и относительно успешный кейс по применению нейросетей в создании историй. Три года назад короткий роман «День, когда компьютер напишет роман», написанный алгоритмом японцев, вышел в финал конкурса авторов. Создатели не только «покормили» нейросеть дата-сетом, но и прописали героев, события. Это был не единственный претендент на победу среди алгоритмов, десяток других нейророманов не вошел в шорт-лист.

Хотя арт-деятели уверены, что творения алгоритмов — это не искусство, в рамки современного искусства вписываются сами эксперименты. Тот же «Портрет Эдмона Белами» ставит вопрос о ценности авторства и рушит нормы рынка, появившегося раньше, чем ученые начали предсказывать появление искусственного разума.

Тот же «Портрет Эдмона Белами» ставит вопрос о ценности авторства и рушит нормы рынка, появившегося раньше, чем ученые начали предсказывать появление искусственного разума.

Анастасия Степанова, Габриэла Чалабова

История падения музыки от Адриана Леверкюна до Дэвида Коупа

Вчера мы в первом приближении рассмотрели экспансию искусственного интеллекта на традиционную площадку творчества — написанное слово. Какими бы впечатляющими ни были достижения компании Narrative Science и её движка Quill, говорить о замене писательского труда в обозримом будущем не приходится. Максимум, на что способен «компьютерный журналист», — это написать удобоваримым языком отчёт с элементами статистического анализа. Даже о намёке на самое примитивное литературное творчество можно не мечтать: AI никогда не заменит не то что Шекспира, но даже Паоло Коэльо (хотя Дэна Брауна лет через десять наверняка скопирует).

Счастье человека (и несчастье Голема) в том, что магия художественного образа обитает по ту сторону информации. Вернее — вообще никакого отношения к информации не имеет. Не случайно даже на заре семиотики (в частности уже в «Открытом произведении» Эко) было понимание того, что в чисто информативном плане художественный образ на несколько порядков превосходит любой научный концепт. Что же говорить о психологических и эмоциональных коннотациях, присутствующих в любом даже самом слабеньком художественном образе и напрочь отсутствующих в самых сложных информационных объектах (то есть научных понятиях)?

Вернее — вообще никакого отношения к информации не имеет. Не случайно даже на заре семиотики (в частности уже в «Открытом произведении» Эко) было понимание того, что в чисто информативном плане художественный образ на несколько порядков превосходит любой научный концепт. Что же говорить о психологических и эмоциональных коннотациях, присутствующих в любом даже самом слабеньком художественном образе и напрочь отсутствующих в самых сложных информационных объектах (то есть научных понятиях)?

О неспособности искусственного интеллекта справиться с художественным текстом (и порождаемой этим текстом образностью) можно говорить очень долго, однако для наших целей хватит понимания самого главного: художественный образ априорно не дискретен и, как следствие, не выводится из информации. Сколько бы Quill ни обрабатывал данных из «Твиттера», биржевой аналитики, политических событий и статистики по недвижимости, AI-движок никогда не сможет вывести из данной в его ощущения эмпирики на подлинный художественный уровень. То есть заменить чисто информационных журналистов у компьютеров получится уже в ближайшее время, заменить же колумнистов, тем более настоящих писателей, не удастся никогда.

То есть заменить чисто информационных журналистов у компьютеров получится уже в ближайшее время, заменить же колумнистов, тем более настоящих писателей, не удастся никогда.

Сегодня, однако, мы поговорим о другом — чрезвычайно тревожном, на мой взгляд, — аспекте экспансии искусственного интеллекта на территории творчества человека. О музыке. Моя тревога объясняется тем, что добиться иллюзии полноценной музыкальной композиции с помощью компьютерных технологий значительно проще, чем имитировать художественный текст. Причина — в силе и одновременно слабости музыки как искусства. Причина — в том, что делает музыку максимально приближенной к Богу (музыка — это квинтэссенция эстетики, высшее искусство) — и в то же время уязвимой для профанации.

Музыка — это эмоция в дистиллированном виде, которая к тому же ещё и оторвана от прямых смыслов. Музыка, подобно поэзии (в большей мере) и прозе (в меньшей), способна породить художественную образность, которая на порядок превосходит по информативности научные понятия, однако все эти образы, порождённые музыкой, будут исключительно опосредованы. То есть будут рождаться в голове слушателя, а не из комбинации музыкальных нот. Ноты создают тональность и настроение, которые, в свою очередь, порождают образы и несут информацию. Сама же музыка — вне информации, вне прямых смыслов.

То есть будут рождаться в голове слушателя, а не из комбинации музыкальных нот. Ноты создают тональность и настроение, которые, в свою очередь, порождают образы и несут информацию. Сама же музыка — вне информации, вне прямых смыслов.

Это качество музыки возносит её над остальными искусствами; оно же, боюсь, её и погубит.

Дэвид Коуп (David Cope) родился в Калифорнии в 1941 году, влюбился в музыку в раннем детстве, получил блестящее образование и обещал затмить самого Гершвина. Юный композитор создал несколько ярких произведений малого жанра, получил восторженные отзывы критики и вместе с ними заказ на создание — ни много ни мало — полномасштабной оперы! В 1980 году Дэвид Коуп сел писать произведение, которое должно было вознести его до небес, и… сломался!

Коуп пыхтел почти полгода, но не сумел создать даже увертюру. Дальше пыхтеть возможности не было, потому что несостоявшийся композитор имел жену и четверых детей, которых нужно было чем-то кормить. И тогда Коуп вспомнил об Адриане Леверкюне и продал душу дьяволу. В отличие от трагического героя Томаса Манна, Дэвиду Коупу не пришлось общаться с нечистой силой: достаточно было подружиться с компьютером!

И тогда Коуп вспомнил об Адриане Леверкюне и продал душу дьяволу. В отличие от трагического героя Томаса Манна, Дэвиду Коупу не пришлось общаться с нечистой силой: достаточно было подружиться с компьютером!

Одной дружбы, как вы понимаете, было мало, требовался ещё некий хитрый изъян в душе, который позволил бы направить энергию в нужное русло. Изъян Дэвида Коупа отлился в сентенцию, за которой скрываются все его убеждения: «Вопрос не стоит — есть ли душа у композитора. Вопрос — есть ли душа у всех нас!»

Для себя Дэвид Коуп решил однозначно (после затяжных вигилий над оперой): души нет! Ни в композиторах, ни в слушателях, ни вообще у остальных людей. А что же есть? Есть технологии!

Поверив в Голема (исполина без души), Дэвид Коуп очень легко нашёл «эликсир счастья». (Хотел написать «формулу успеха», но вовремя одумался: успех в «творчестве» Коупа, слава тебе, господи, не ночевал ни разу!) Как работали великие композиторы, если не имели души, а музыка не была отражением небесных сфер? Великие композиторы, рассудил Дэвид Коуп, внимательно слушали! Слушали других композиторов — своих современников и предшественников. В результате их мозг «рекомбинировал» услышанные мелодии и музыкальные фразы. Рекомбинировал на собственный — оригинальный — лад.

В результате их мозг «рекомбинировал» услышанные мелодии и музыкальные фразы. Рекомбинировал на собственный — оригинальный — лад.

От этой идеи рукой подать до компьютерных технологий, способных «писать музыку». Из великого музыкального наследия человечества создаётся база данных на основе как можно большего количества элементарных музыкальных фраз — мотивы, мелодии, яркие аккорды, переходы и т. п. После чего компьютеру даётся задание: перетасовать эти элементарные фразы таким образом, чтобы получилось нечто оригинальное!

Первой жертвой Дэвида Коупа стал Иоганн Себастьян Бах. В 1983 году новый доктор Фаустус разложил творчество великого немца на составляющие, затем перекомбинировал их и «создал» новый хорал. «В стиле Баха». Из этих экспериментов родилась Emmy — первый движок искусственного компьютерного интеллекта, приспособленный к написанию музыки.

Новые мощные процессоры открыли перед Дэвидом Коупом головокружительные перспективы: однажды утром он запустил Emmy и отправился завтракать, а по возвращении с восторгом обнаружил, что его Мефистофель наштамповал 5 тысяч новых — «оригинальных» — хоралов Баха! В 1993 году Дэвид Коуп выпустил свою первую пластинку, названную Bach by Design (Centaur Records, CRC 2184).

В 1997 свет увидела «Классическая музыка, написанная компьютером» («Classical Music Composed by Computer»), следом, чуть позже, — «Виртуальный Моцарт» («Virtual Mozart». 1997), «Виртуальный Бах» («Virtual Bach», 2003).

Затем наступила пауза. Дело в том, что музыкальные критики встретили «творчество» Дэвида Коупа не то что в штыки, а просто с ненавистью. Каждая новая пластинка воспринималась как личное оскорбление любым человеком, который был связан с музыкой или просто любил её. Рецензии на опусы получались зубодробительными, однако все они сводились к одному лейтмотиву: «В этой музыке нет души».

Дэвид Коуп негодовал, насмехался, предлагал пари, настаивая на невозможности отличить работу живого композитора от продукции его Emmy. Стену непонимания и отторжения пробить не удавалось. Сначала Коуп недоумевал, а потом его в очередной раз осенило: чем его Emmy хуже великих музыкальных классиков? Тем, что они уже умерли, а Emmy пока жива! Вот если её умертвить, то творчество её получит необходимый импульс для признания. (Вот и начался «Доктор Фаустус» по полной программе!)

(Вот и начался «Доктор Фаустус» по полной программе!)

В 2003 году Дэвид Коуп «убивает» свою Emmy и шесть лет ничего не «пишет». Все это время профессор музыки в Калифорнийском университете (мирское прикрытие Коупа!) лепит нового Голема — «дочку» Emmy, Emily Howell, использующую гораздо более солидные компьютерные мощности (Emmy питалась соками допотопного Power Mac 7500).

В память вложено творчество 36 композиторов («От Палестрины до самого Дэвида Коупа»), из которого неоголемша лепит оригинальные музыкальные фразы. Сам доктор Фаустус сидит рядом и помогает компьютеру делать «правильный выбор»: бракует мелодии и аккорды, выбирает из десятка ходов такой, который, на его личный взгляд, больше понравится публике.

В 2009 Коупа / Emily Howell прорвало: выходит пластинка From Darkness, Light (Emily Howell), затем подряд три симфонии (№4, №5 и №9), два струнных квартета, концерт для скрипки, концерт для виолончели, концерт для пианино. Доктор Фаустус внутренне уже созрел, чтобы закричать «Verweile doch, du bist so schön!», однако музыкальное сообщество, как и раньше, не даёт расслабиться: что бы ни выдавал на-гора «композитор», оплодотворённый искусственным интеллектом, он тут же подвергается беспощадной критике. С прежним мотивом: нет души!

С прежним мотивом: нет души!

Я внимательно прослушал образцы «творчества» Дэвида Коупа / Emily Howell (на YouTube самим демиургом выложено 371 видео) и вот что подумал: если бы в 1993 году Коуп никому не сказал, что его музыку пишет не он сам, а компьютер, никто бы никогда не догадался! И это — самое страшное.

Безусловно, любой искушённый в музыке человек мгновенно усмотрит нескончаемую «цитацию», однако это обстоятельство можно смело выдать за расхожий приём постмодернизма без ущерба для эстетического эффекта, который от заимствований (или — отсутствия оных) никак не зависит. Эстетический эффект либо есть, либо его нет. На мой взгляд, во многих «творениях» музыкального доктора Фаустуса этот эффект однозначно присутствует, хотя «души» там нет. Причина — та же, что помянул вначале: в отличие от художественного текста, образность музыки рождается не в самой музыке, а в голове слушателя (ноты лишь стимулируют появление этой образности, подобно психотропным веществам).

Самое ужасное, что к творчеству Дэвида Коупа в последнее время с образцовым напором подбираются дельцы попсовых развлечений. В отличие от сообщества любителей классики, бритнёвая спирсня совершенно лишена щепетильности и с лёгкостью обменяет душу (которой все равно у неё нет, как нет у Голема) на звонкую монету. По этой причине, если только Emily Howell начнёт штамповать вместо импровизаций в стиле Баха хиты для MTV, успех затмит самые смелые ожидания.

Вопрос: учитывая всё сказанное, можно ли ожидать, что через 10 лет вся рок-музыка будет создаваться компьютерами целиком — от первой ноты до последнего скэта?

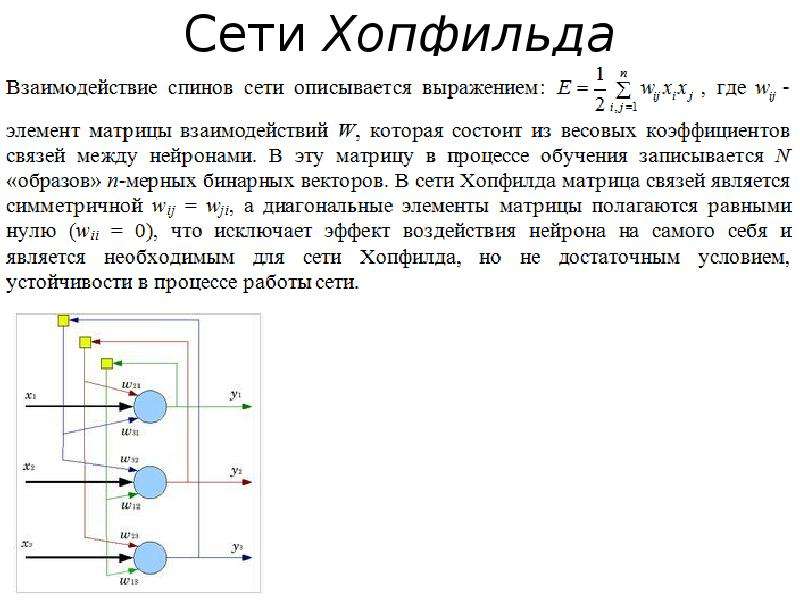

Нейросети и кого в них ловят

Автор: Георгий Куриленко, гик («увлечённый высокими технологиями человек»)

Нейросети – это одна из форм организации искусственного интеллекта (ИИ). Мы можем у него многому научиться, потому что он выходит из привычной человеку плоскости. Его мышление не ограничено рамками наших стереотипов. ИИ использует невообразимые для нас алгоритмы и за счёт этого побеждает: в шахматы, в го, в StarCraft, в диагностику рака. И скоро «уделают» нас даже в музыке и живописи!

ИИ использует невообразимые для нас алгоритмы и за счёт этого побеждает: в шахматы, в го, в StarCraft, в диагностику рака. И скоро «уделают» нас даже в музыке и живописи!

Дотошные нейрофизиологи подсчитали, что в человеческом мозге 86 миллиардов нейронов. Если провести аналогию с компьютером, то получится 86 миллиардов бит информации. Но скажу сразу: такая аналогия ошибочна. Это всё равно что представить себе сравнение мозга, на ранних этапах развития техники, с телеграфом. История про 86 миллиардов «транзисторов» настолько же отражает действительность, как и сравнение с примитивным электрическим устройством. Просто в силу умственных способностей нам так проще.

Также подсчитано, что мощность мозга составляет приблизительно 25 Ватт – это как четыре работающих зарядки для современного мобильного телефона.

Мозг занимает 1,5-2% массы тела. Даже у муравьёв соотношение процента мозга к остальной массе тела больше! И при этом наш мозг потребляет 25% энергии всего организма. По сути, если вы будете целый день просто лежать целый день на диване, то уже потратите четверть своей энергии на одну только работу вашего мозга, я уже не говорю про пищеварение, кровообращение, дыхание и прочее. Мозг действительно очень энергозатратный. Наш организм скупой, не хочет тратить ресурс, ему проще накопить жирок, быть более энергоэффективным. Поэтому любой орган, который потребляет четверть ресурса всего организма – это нонсенс для естественной системы.

По сути, если вы будете целый день просто лежать целый день на диване, то уже потратите четверть своей энергии на одну только работу вашего мозга, я уже не говорю про пищеварение, кровообращение, дыхание и прочее. Мозг действительно очень энергозатратный. Наш организм скупой, не хочет тратить ресурс, ему проще накопить жирок, быть более энергоэффективным. Поэтому любой орган, который потребляет четверть ресурса всего организма – это нонсенс для естественной системы.

Объём памяти мозга может достигать 1016 бит – это более 1250 терабайт. И тут тоже есть разные точки зрения, что терабайт значительно больше, ведь цифра была получена исключительно анализом нейронов. А помимо них существуют ещё и синапсы, то есть связи нейронов между собой, и отдельные белки в мозге. Это лишь предположение, мы не можем посчитать объём мозга, просто как флешки.

Средний размер мозга уменьшился, как говорят антропологи, за последние 40 тысяч лет на 150 грамм. Вот хороший вопрос, почему мы тупеем https://un-sci.com/ru/2020/01/13/idiotokratiya-skolko-let-ostalos-do-pobedy-gluposti/ ? Если всю историю мы наращивали мозги, то тут не только притормозили, а ещё и сдали назад. Но ведь реально же не надо ничего знать, для того чтобы делать посты в Инстаграме! Не надо быть экспертом в какой-то области, достаточно просто выполнять свою работу на среднем уровне. Мы из эры Гутенберга движемся в эру Цукерберга, как сказал кто-то. Мы тупеем как индивидуалы, но умнеем как вид, потому что можем наращивать объёмы информации, которая у нас имеется.

Чего мы не знаем о мозге? Ответ прост: ничего. Все наши познания крайне точечны. Мы примерно представляем, куда нужно ударить током человеку в мозг, чтобы он почувствовал радость, испытал оргазм либо чтобы увидел какие-то галлюцинации. Но как это глобально взаимосвязано, мы не понимаем.

В компьютере одна конкретная единица выполняет одну свойственную ей функцию. Это либо память, либо процессор (то есть, вычислительная способность), либо это программа. У нас всё это вместе: каждый нейрон одновременно выполняет и функцию запоминания, и функцию мышления, при этом он может связываться с другими нейронами по собственной воле. У нас до 25 лет прорастают сквозь мозг новые нейронные связи.

Лет шесть назад произошёл любопытнейший случай: у человека начала неметь нога, он обратился к врачам, те обследовали его в томографе – и МРТ показало, что у этого мужчины 90% мозга отсутствует! Есть только кора, а всё, что внутри, заполнено жидкостью. При этом его IQ был 75. У умственно отсталого IQ 70, то есть всё, что выше 70-ти, считается нормальным человеком, он абсолютно обладает всеми теми же правами, что и мы с вами, может водить машину, вступать в брак, заключать сделки. У того мужчины даже было двое детей! То есть, с эволюционной точки зрения он выполнил своё предназначение. Имя этого человека не разглашается, ему было 44 года, и всю свою жизнь он жил с гидроэнцефалитом – так называется это заболевание. Медики выяснили, что по мере того, как его мозг разрушался под действием этой жидкости, другие отделы мозга перенимали на себя функции. Это можно посмотреть также на примерах жертв катастроф, неудавшихся самоубийц и перенесшими инсульт. Этот процесс называется нейропластичность. У мужчины одна кора переняла на себя все иные функции. При этом он вполне успешно работал чиновником!

Как устроено наше мышление? Есть клетки мозга нейроны, а связи между ними это синапсы. Когда сигнал поступает к нейрону, он либо достаточно сильный, чтобы пройти дальше, либо недостаточно сильный, и тогда он тормозится. И в зависимости от того, как мы проходим дальше, и происходит вычисление. Естественно, всё это происходит в трёхмерном пространстве. Допустим, нам надо отличить апельсин от банана. Мозг оценивает цвет, форму, запах, фактуру поверхности, и «взвешивает» информацию, передаваемую каждым нейроном. Как заставить ИИ отличать апельсин от банана и собачек от котиков? Мы берём так называемый «случайный шум», даём специальной нейросети – Генератору, — которая берёт шум, находит знакомые очертания и на основании этих очертаний достраивает изображение котика. Дальше берём выборку собачек из интернета и берём нейросеть под называнием Дискриминатор, которая должна оценивать, похож ли этот зверёк на собачку. Если похож, то всё нормально, отправляем пользователю. Если не похож, то отправляем на вторичную переработку. Так работают современные генеративно-дискредитивные системы. Это похоже на соревнование фальшивомонетчика и полицейского. Полицейский постоянно старается подделать купюру, а полицейский смотрит на оригинал и ищет мелкие отличия. То есть и Генератор, и Дискриминатор постоянно учатся находить всё более и более тонкие отличие. Если вы не собачка а котик, значит, всё отправляется на второй круг.

Но до сих пор – ура! — то, что для нас является элементарным, для ИИ является непреодолимой задачей. Курьёзны примеры, когда ИИ не мог различить на фото крупного плана, где чихуахуа, а где кекс с черникой, или собачек, которые свернулись калачиком, от реальных калачиков. Или шпицев от печенек, или щенков от жареной курочки. Нам не нужно детально разбирать изображения, чтобы понять, что это. А машины анализируют изображения попиксельно, определяя связи между этими пикселями. Причём желательно, чтобы они были чересчур контрастными, чтобы выделить все неровности и шероховатости. С «белым шумом» панда будет уже восприниматься ИИ как гиббон.

Мы до сих пор во многом превосходим ИИ, но он уже наступает нам на пятки. Если вы думаете, что делаете музыку лучше, то это ненадолго. Музыка, полностью написанная ИИ, уже существует (концерт для нескольких музыкальных инструментов), ничем не уступая Мусоргскому или Рахманинову. Не так давно официально был заключен контракт между звукозаписывающим лейблом и производителем программного обеспечения, чтобы мы могли покупать диски, написанные нейронными сетями. Коммерческая индустрия с большей охотой будет покупать дешёвую музыку, написанную нейросетями – просто вам для заметки.

Картины, в правом углу которых вместо имени художника подписан математический алгоритм, который генерировал эту картину, уже продавались на аукционах за тысячи долларов. Но успехи ИИ в живописи характеризуются не только абстрактным искусством и приложениями для смартфонов, которые могут «переводить» вас или ваших животных в картины, якобы написанные известными художниками (вам достаточно выбрать стиль, и любое изображение будет в него преобразовано), но и головокружительными способностями восстанавливать, воссоздавать утерянные шедевры! Известен случай с картиной Пикассо под названием «Старый гитарист», которую просканировали при помощи мощных рентгеновских сканеров, и под ней была обнаружена другая картина (холсты были очень дорогими, и художник рисовал поверх своих старых работ). «Нижнюю» картину отсканировали при помощи нейросети, а потом использовали ещё одну картину Пикассо для того, чтобы взять оттуда авторский стиль, и таким образом нейросеть сама разукрасила чёрно-белое после сканирования «нижнее» изображение обнажённой женщины. То есть, мы фактически восстановили потерянный шедевр Пикассо, спустя очень много лет после написания. Кстати, под Моной Лизой тоже есть её устаревшие версии!

ИИ может даже уже читать и визуализировать наши мысли. Людей поместили в томограф и сканировали их активность мозга, когда им показывали разные картинки. Нейросеть восстанавливала изображения по волнам мозга. Бокал пива, к слову, угадывается лучше всего! Эта же технология может помочь нам визуализировать сны. Если у вас перед глазами текст, то для ИИ не проблема будет его прочитать по мыслям. Нейросеть уже без проблем распознаёт цифры, которые «слышит» по волнам мозга и безошибочно реагирует на счёт от 1 до 10.

Надо сказать, что мы сами всячески приближаем тот день, когда ИИ станет в разы обученнее нас. Например, мы учим его, когда нам для входа на сайт предлагают капчу – выбрать везде где машины, или где пешеходные переходы. Так мы учим ИИ, который отвечает за беспилотные автомобили. Если верить предсказаниям Рея Курцвела, коммерческого директора Google, компаниям в Америке запретят производить автомобили без автопилота. А предсказания этого человека обычно сбываются с точностью до года.

Впервые в истории летом 2019 года нейросеть создала вакцину от гриппа (уже ведутся её испытания на людях!). Да ещё и сделала таким образом, что вакцина а) усиливает иммунитет и б) способна генерировать новые соединения белков, которые ранее были неизвестны. Дело в том, что грипп гораздо быстрее может мутировать, чем мы: нам, чтобы мутировать, нужно перенести свои гены, то есть размножиться, дать потомство. А у вирусов и бактерий есть такой инструмент, как бесконтактный перенос генов. То есть если бактерия попадает во враждебную среду, она может обменяться геномом с другими бактериями и перенять у них эффективные наработки – поэтому вирусы очень быстро мутируют, приспосабливаются к условиям. Именно поэтому нельзя пользоваться антибиотиками без назначения врача, либо не пропивать до конца курс: вы убьёте только часть бактерий в своём организме, а остальная, наоборот, получит резистентность к этому виду антибиотика. Изобретатель пенициллина Флеминг даже сам предсказывал, что рано или поздно его панацея потеряет свои свойства. И сейчас уже никто не лечится пенициллином – он был эффективен в 40-50-е годы, и с тех пор все бактерии приобрели к нему иммунитет.

Другая нейросеть создала лекарство от мышечного фиброза за 21 день. Так называемые Big Pharma, то есть компании, которые занимаются производством лекарств, тратят на них миллионы долларов и годы тестирования – поэтому лекарства такие дорогие. А тут было потрачено всего 150 тысяч долларов. По меркам фармацевтической промышленности, это копейки. Так что в 2020 году можно ждать новые кейсы, когда ИИ обеспечивает нас ещё теперь и лекарствами.

Вспомним хронологию, как развивались нейросети. В ХХ веке возникли алгоритмы и наука кибернетика. В 70-90-е годы настала так называемая «зима искусственного интеллекта» — застой, ничего не происходило, потому что не было возможности обучать нейронные сети. Это сейчас у нас есть очень много цифровых изображений – а тогда, чтобы оцифровать фото, нужно было потратить очень много усилий, причём даже если был бы некий сканер. Застой был преодолён окончательно с изобретением новых алгоритмов, основанных на большой базе данных – то, что называется во всём мире Big Data, и к 2010 году в этом деле произошёл ощутимый прорыв, нейросети стали делать очень зрелищный результат. Каждый раз, когда вы лайкаете чьё-то фото, или с кем-то переписываетесь, или разговариваете по скайпу – интернет всё это запоминает. Это не выкладывается в открытый доступ, это не персонализировано (что конкретный человек говорил то-то и то-то) – просто это всё складывается в одну общую базу данных, которая впоследствии служит для обучения ИИ. Мы когда пользуемся этими всеми сервисами бесплатно, мы подписываем пользовательское соглашение, кликаем «принять». Если бы вы читали это соглашение, для вас не было бы новостью то, что я сейчас рассказываю. А так мы даже зачастую не знаем, что наша личная информация и все наши бизнес-тайны используются скопом для обучения некоего ИИ https://un-sci.com/ru/2020/01/03/bog-3-0-ili-pobeda-nad-smertyu-strashnee-yadernoj-bomby/.

С 2016 года начался бум коммерческого применения нейронных сетей. Сейчас есть люди, которые на этом неплохо зарабатывают, а до того это всё было просто интересным развлечением.

Моя любимая книга — «Мечтают ли андроиды об электроовцах?» Артура Кларка. По ней был снят фильм «Бегущий по лезвию бритвы» Ридли Скотта 1982 года (уже вышло его продолжение, в котором действие происходит в 2049 году). Книга об отношениях человека с ИИ: способна ли мыслящая машина чувствовать, а не просто имитировать свои чувства. И вопрос в фильме стоит: а способен ли чувствовать ты? Или сам тоже просто имитируешь чувства?

Все помнят 1997 год, когда человек впервые проиграл, как тогда шутили, калькулятору. На самом деле, это был суперкомпьютер компании IBM под названием Deep Blue и поединок с ним Гарри Каспарова. До тех пор никто не верил, что человек не может проиграть машине в шахматы. Может, он хуже считает, с умножением-делением справляется похуже. Но в шахматах нельзя просто перебирать ходы, там их слишком много! И железкина грубая сила, brutal force, не подходит для того, чтобы играть в шахматы. Но в 97-м году компания IBM взяла и разрушила все эти стереотипы, и теперь уже любое соревнование человека и компьютера в настольной игре расценивают как соревнование между боксёром и младенцем (разумеется, в роли «боксёра» нейросеть). Человек никогда уже не достигнет того уровня, на котором играют компьютеры. Каспаров не соглашался с этим проигрышем, утверждал, что были люди, которые специально обучались на его играх, исследовали их и запрограммировали компьютер – короче, много придумывал отмазок для того, чтобы не признать результат. Но факт остаётся фактом: люди никогда с тех пор в шахматы не выигрывали. «Мне всегда было интересно, как это будет, когда высшие существа приземлятся на Землю и покажут нам, как они играют в шахматы. Теперь я знаю», — сказал об этом скандинавский гроссмейстер Петер Хайне Нильсен.

2016 год ознаменовался победой нейросети AlphaGo над корейским игроком в го Ли Седоля, профессионала 9-го дана, то есть высшего ранга. До того люди были уверены, что ладно шахматы, но в го компьютер точно не сможет обыграть человека, потому что эта древняя китайская игра требует много фантазии, интуиции, абстрактного мышления и тому подобное. Это не игра, а искусство и философия. Школы го уже несколько сотен лет непрерывно подготавливают гроссмейстеров, изучают все ходы, которые были сделаны за всю историю игры; нестандартные решения приобретают даже названия: «Лестница в небо», «Выход дракона» – азиаты такое любят. Но компания DeepMind из Великобритании, которая сейчас принадлежит Google, сделали свой самообучающийся алгоритм, который не разбирался в самых крутых партиях в го, вообще ничего не знал об этих традициях, он учился играть заново, сам, поэтому многие решения этого алгоритма признавались просто дурацкими. Первый ход, который сделала эта программа, все специалисты по го сочли абсолютно проигрышным – но самое интересное, что в конце партии всё замкнулось именно на этот первый ход. Эта программа разрушила представление корейцев, японцев и китайцев о том, что такое го. И на сегодняшний момент всё обучение у них происходит только по играм этого алгоритма. А это что-то да значит: общеизвестно ведь, насколько трепетно консервативные азиаты относятся к своей истории. Побеждённый корейский гроссмейстер Ли Седоль объявил после исторической игры об уходе из этого спорта. Он сказал: «больше нет смысла соревноваться в том, в чём ты никогда не поднимешься на высоту». На даный момент технологии ушли далеко вперёд, и итог действительно известен заранее.

В следующем 2017 году та же компания DeepMind «выкатывает» новый алгоритм AlphaZero, который учился на играх с самим собой, проведя сотни тысяч «поединков». За 4 часа он обучился игре в шахматы, за 8 часов в го. И каждый раз немножко улучшал свой алгоритм. Научился играть и в сёги, и в шашки – не осталось ни одной настольной игры, которая не далась бы этому компьютеру. Для сравнения: DeepBlue 1997 года умел играть только в шахматы, а эта найросеть – может всё, потому что она не имеет чёткой инструкции, она адаптируется к правилам игры. Она может учить правила на ходу и в соответствии с ними выбирать правильные решения. И вот на сей раз DeepMind уже устроили не соревнование человека и машины, а соревнование двух алгоритмов. AlphaZero победил в борьбе с каждым чемпионом мира среди программ, и Stockfish, и Elmo, за 24 часа сражений с ними достигнув сверхчеловеческого уровня игры.

Компания DeepMind прекратила своё соревнование в играх и полностью переключилась на медицину. Те алгоритмы, которые были наработаны при помощи игр, сейчас используются для диагностирования рака. В 2017 году 18 топовых онкологов Китая проиграли в точности диагностики программе, построенной на этих алгоритмах. Она диагностировала на 7-15% точнее, в том числе потому, что использовала не двухмерные, а трёхмерные сканы МРТ.

В последний раз Deep Mind занялась геймерскими соревнованиями в 2019 году. Существует такая стратегическая игра StarCraft II от компании Blizzard. В Корее она приобрела статус просто культовый, там очень много подростков, которые реально зарабатывают на этой игре. У них есть крутые спонсоры из всяких мировых компаний. Очень долгое время считалось, что компьютерные игры, киберспорт, это слишком большая сложность для ИИ. Здесь чётких правил нет, вы должны одновременно атаковать противника, следить за своими ресурсами, простраивать свою базу, управлять своим юнитом. Но новая найронная сеть под названием AlphaStar просто в пух и прах разнесла двух топовых игроков StarCraft II, европейцев. Причём они признавали, что тактика и способ ведения боя нейросети полностью отличался от человеческого и не был понятен до конца. Она использовала некие новые модели игры, которые сейчас воспринимаются геймерами и применяются уже в матчах между людьми.

Мы можем многому научиться у ИИ, потому что он выходит из привычной нам плоскости мышления. Его мышление не ограничено нашими стереотипами и рамками.

Очень интересная игра от компании Unity, графический движок Obstacle Tower Challenge поставил, впрочем, ИИ перед новым вызовом. Это трёхмерная игра-лабиринт, и нужно дойти до сотого уровня башни – за это была предусмотрена премия 100 тысяч долларов. Самые крутые игроки доходили до 10-го. А компьютер дошёл до 19-го. Игра оказалась очень сложной и процедурно генерируемой: не было такого, что уровни повторялись два раза подряд. Каждый раз даже разработчики не знали, как будет выглядеть следующий уровень, потому что создание уровня происходило непосредственно во время игры, и игра могла адаптироваться. Соответственно, даже самые крутые нейронные сети проходили эту игру только до 19 уровня.

На этом видео https://youtu.be/gn4nRCC9TwQ вы видите очень интересный пример, где нейронная сеть учится передвигаться, будучи перемещённой в реальную физическую обстановку. То есть здесь сила трения, сила гравитации, момент импульса полностью соответствуют реальным, просто они простроены в программной среде. Изначально нейросеть не умела ничего – у неё были просто ноги. И она сама научилась не просто ходить, а ещё и бегать, преодолевать препятствия, перепрыгивать большую дистанцию, ходить по пересечённой местности. Ребёнок точно так же учится ходить, процесс идентичен, что настройка нашей нейросети, что настройка искусственной нейросети. Но дети-то учатся ходить годами, а нейросеть научилась за считанные дни. Дело в том, что у нее было гораздо больше попыток и она могла этим заниматься постоянно, без перерывов на сон, еду и отдых. Да, и ей не надо было заранее описывать, как подниматься по лестнице – она может сама научиться! Поэтому я с предвосхищением жду следующее поколение роботов…

При «дип фейки» скандал отгремел уже почти год назад, когда нейросеть могла смоделировать видео любого политика, говорящего какую угодно чушь. Но вот это видео https://youtu.be/5rPKeUXjEvE, на котором лицо Джона Малковича перетекает в лицо актёра из «Король говорит», потом в Аль Пачино, «Люди в чёрном», Джорджа Клуни, Энтони Хопкинса, Моргана Фримана, «Во все тяжкие», Кристофа Вальца, Джонни Кэша, Гэндальфа и так далее – оно меня просто потрясло! Это настоящий актёр, который менял свой голос, но лица ему подстраивала нейросеть. Это означает одно: кинокомпаниям уже совсем скоро не надо будет тратить миллионы долларов за привлечение ДиКаприо в свой фильм, а можно будет просто купить за пару тысяч его лицо и сделать электронного ДиКаприо. Уже сейчас можно существенно сэкономить на гриме, что и продемонстрировал фильм «Ирландец», который будет номинироваться в этом году на «Оскар»: Де Ниро и Джонни Кэша полностью омолодили без помощи грима, а только использованием ИИ.

Следующее видео https://youtu.be/p3HWpBScjpA слабонервным просьба не смотреть. Это, грубо говоря, смерть нейронной сети. Справа нейроны, которые потихонечку отключаются, а слева изображение человека, по мере того как оно генерируется и страдает от отключения разных нейронов. Мы видим выцветание изображения, у него теряются мелкие детали, и со временем полное преображение. «Сон умирающей нейросети» похож на те процессы, которые происходят у пожилых людей – старческая деменция выглядит примерно вот так с научной точки зрения. То есть это реально слабоумие нейронной сети, в результате которого от симпатичного портрета девушки остаётся вот этот Франкенштейн.

Мой вывод такой. Все видели на картинках, какие орудия труда мы использовали 2,5 млн лет до нашей эры. Животные, которые их использовали, ещё не были людьми. Если мы возьмём другую картинку, на которой изображён сборочный цех крупного производства с роботами и немного абстрагируемся, то мы поймём, что это одно и то же. Роботы, как и допотопные орудия труда, созданы, чтобы нам меньше работать. Лень двигает прогресс. ИИ – это просто следствие развития нашей лени. Сначала мы думали, что хотим меньше работать, потом мы поняли, что мы хотим вообще не работать, а теперь мы понимаем, что мы и думать-то не хотим. Знаете, у пауков есть внешнее пищеварение: они впрыскивают свои желудочные соки в жертву и потом просто всасывают уже переваренный материал – так и у нас: будет просто внешнее мышление. Зачем думать головой, если мы создали смартфончик, который думает за нас.

__________________________

Читайте нас в телеграм

https://t.me/granitnauky

Поделиться ссылкой:

Моцарт, Стив Райх, Йоко Оно и другие авторы арт-генераторов в обзоре Алексея Шульгина

Состязания роботов-гитаристов, которыми хвалился Вертер в «Гостье из будущего», уже устраиваются – искусство вполне по силам машинам. По просьбе «Афиши Daily» Алексей Шульгин рассказал о том, что такое арт-генераторы, и привел примеры алгоритмических произведений у Йоко Оно, Стива Райха и «Яндекса».

В «Электромузее», входящем в объединение «Выставочные залы Москвы», открылась выставка «Автоматическая душа» — об алгоритмическом искусстве, арт-генераторах, машинной музыке. Тема скользкая: искусство, созданное с помощью компьютера, пока не получило того же статуса, что и искусство обычное, человеческое. Порой сами художники не могут с уверенностью сказать, кто автор их произведения — они или машина. Куратор выставки медиахудожник Алексей Шульгин, читающий в Школе Родченко курс по алгоритмическому искусству, объясняет, что такое арт-генераторы и почему за ними будущее.

«Музыкальная игра в кости» («Musikalisches Würfelspiel»)

Вольфганг Амадей Моцарт, 1770–1780-е

На австрийском телеканале показали, как играть в игру, придуманную Моцартом

Первый в истории человечества арт-генератор создал Моцарт — с его помощью он сочинял менуэты. Дело в том, что музыка сама по себе алгоритмична. Все в ней подчиняется каким-то законам: размер, темп, обязательные части, такт и прочее. И все менуэты во времена Моцарта создавались в рамках менуэтного канона, в котором присутствовали строгие ограничения. А если присутствуют ограничения, то разнообразие достигается за счет вариативности. Видимо, автор увидел, что разные фрагменты менуэтов можно менять друг с другом. Для выбора фрагмента Моцарт придумал кидать игральные кости. Выпавшее число определяло номер музыкального фрагмента — уже сочиненного и отложенного впрок, — который должен стать частью пьесы.

Студенты в Школе Родченко, где я читаю курс в том числе и про алгоритмическое искусство, конечно, от такого офигевают. Для них все эти понятия — генератор случайных чисел, рандомность — современные термины. Но тут выясняется, что ими пользовался Моцарт еще в XVIII веке! На нашей выставке «Музыкальная игра в кости» будет представлена просто и без изысков. Подходишь к тачскрину, нажимаешь кнопку, а тебе автоматом генерируется менуэт. Важный вопрос, который нужно самому себе задать в этот момент, звучит так: а кто автор этих произведений? Работая с программным обеспечением, мы не являемся однозначными авторами того, что делаем. Кто-то ведь уже написал этот самый софтвар — и автоматически стал нашим соавтором. Моцарт — автор несколько музыкальных фрагментов, он же придумал, как выбрать из них один, но является ли он автором каждого сгенерированного произведения? Может, автор тот, кто бросил кости и инициировал создание произведения?

«Уральские напевы»

Рудольф Зарипов, 1959

Зарипов за работой

Советский математик и программист создал первый арт-генератор в СССР. Впервые об автоматизированном способе сочинения музыки он задумался еще во время учебы в музыкальном училище, но к созданию его приступил уже в аспирантуре, работая на ЭВМ «Урал». Машинное конструирование мелодий долго не шло на лад — Зарипов видел бесконечное многообразие мелодических оборотов, но никак не мог найти одну изящную формулу, все их объединяющую. И только в 1959-м алгоритм наконец был написан, и машина «сочинила» три вальса и несколько маршей. Сам Рудольф Зарипов называл эти музыкальные произведения «Уральскими напевами» — в честь композитора, то есть машины.

Про Зарипова есть один момент интересный. Когда он начал создавать компьютерную музыку, его страшно клеймили советские искусствоведы. Говорили, что в этой музыке нет человека, что машины не могут делать искусство. И тогда он на большом симпозиуме, где были и композиторы, и музыканты, и ученые, устроил слепое прослушивание: взял несколько произведений, написанных машиной, и несколько произведений современных советских композиторов. Не объявляя, человек это написал или машина, он ставил одно произведение за другим, а аудитория оценивала их по разным критериям. В итоге средняя оценка машинного искусства оказалась выше, чем оценка искусства человеческого. То есть людям больше понравилось то, что машина написала. Зарипов все документировал — много писал в журналы «Знание — сила», «Музыка и время». У нас выставке будет представлено одно произведение из «Уральских напевов».

«Instructions»

Йоко Оно, 1961

Здесь и далее – инструкции Йоко Оно

1 из 4Вдова Джона Леннона точно так же, как и Моцарт, казалось бы, совсем из другой области. Она никогда не занималась алгоритмическим искусством — ее стихия концептуализм. В начале 1960-х у Йоко был проект: она сочиняла и печатала на листах бумаги коротенькие инструкции по созданию произведений. То есть фактически писала код, который можно выполнить, в результате чего может родиться произведение. Например, была такая инструкция: «Вырежи отверстие в сумке, наполненной разными семенами, и помести эту сумку туда, где есть ветер». Фактически это доказывает, что ноги генеративного искусства растут из концептуализма. Однако арт-истеблишмент во все времена принижал значение медиаискусства, в том числе компьютерного, и потому связь эта для многих не так очевидна. Хотя на самом деле одно перетекает в другое совершенно естественным образом.

Есть и другие примеры. Например, работы американского художника Ла Монте Янга — композитора, экспериментатора. В 1960-м он создал произведение, которое так и называлось «Draw a Straight Line and Follow It». А это уже чистый линк между концептуализмом и алгоритмическим искусством.

Исполнение «Compositions 1961» Янга в Университете Хаддерсфилда, Англия

Конечно, в корне алгоритмического искусства не один только концептуализм. Вариативность заложена в природе любого художественного творчества. Если мы возьмем, к примеру, работы художника Модильяни, то увидим, что они все очень похожие: голые женщины лежат или сидят, одинаковый тип лица, одинаковые фигуры. Видно, что есть некая основа, вокруг которой развиваются вариации. Это значит, что в голове у художника Модильяни была программа с неким генератором случайных чисел: тут она потолще, тут похудее, тут более вытянутая, смотрит немножко сюда или туда. У любого художника, у которого есть свой узнаваемый стиль, в голове сидит алгоритм, по которому он работает. Он сам его создает и сам осуществляет.

Но не всегда непосредственно собственными руками. Возьмем Дэмиена Херста, у которого есть серия работ с точечками, с кружочками цветными, которые рисовали на фабрике другие художники. То есть тут уже он сам взял алгоритм и выдал его другим художникам, которые нарисовали по нему картины. И это, как и в случае с Модильяни, тоже своеобразное алгоритмическое искусство. Жаль только, что алгоритм в голове Модильяни уже не прочтешь.

«Clapping Music»

Стив Райх, 1972

Знаменитый американский композитор-минималист Стив Райх придумал алгоритм создания минималистической музыки. Вернее, не сам придумал, а скорее позаимствовал в традиционной африканской и балинезийской музыке, которую изучал в течение своей жизни. Самая известная композиция Стива Райха, в которой он использует индонезийский народный прием, известный как «сдвиг по фазе» (phase shifting), — это «Clapping Music». Вот музыкальная фраза, она исполняется синхронно двумя музыкантами, восемь раз она повторяется, а на девятый — один исполнитель сдвигается на один такт, потом через восемь повторений сдвигается еще раз и так далее. Вообще вся минималистическая музыка устроена примерно похоже — почти везде заданы паттерны и алгоритм, по которому они воспроизводятся.

«Magic Hand of Chance»

Роман Веростко, 1982

Американский художник Роман Веростко знаменит тем, что в начале 1980-х, используя тригонометрические формулы, научил компьютер рисовать абстрактные картины. Сейчас уже понятно, что задать компьютеру код, выполняя который он изобразит синусоиду, не особенно и трудно. Но Веростко был одним из первых, кто осмелился заявить, что красота математической формулы и синусоиды — это тоже искусство. К сожалению, до сих пор это не общепринятый факт.